Idea java和scala混合打包遇到的各种坑

1、采用默认java的maven配置,运行时发现scala的包没打进去。

发现需要配置scala的编译器,网上有2种方式:

方式1:

<plugin>

<groupId>org.scala-tools</groupId>

<artifactId>maven-scala-plugin</artifactId>

<version>2.15.2</version>

<configuration><</configuration>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

</plugin> 方式2:

<plugin>

<groupId>net.alchim31.maven</groupId>

<artifactId>scala-maven-plugin</artifactId>

<version>3.2.2</version>

<configuration>

<recompileMode>incremental</recompileMode>

</configuration>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

</plugin>

2、编译时scala外部依赖包没找到

需要添加

<configuration>

<args>

<!-- 编译时使用 libs 目录下的 jar 包,通过 mvn scala:help 查看说明 -->

<arg>-extdirs</arg>

<arg>D:/code/spark/jars</arg>

</args>

</configuration>完整配置如下:

<plugin>

<groupId>net.alchim31.maven</groupId>

<artifactId>scala-maven-plugin</artifactId>

<version>3.2.2</version>

<configuration>

<recompileMode>incremental</recompileMode>

<args>

<!-- 编译时使用 libs 目录下的 jar 包,通过 mvn scala:help 查看说明 -->

<arg>-extdirs</arg>

<arg>D:/code/spark/jars</arg>

</args>

</configuration>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

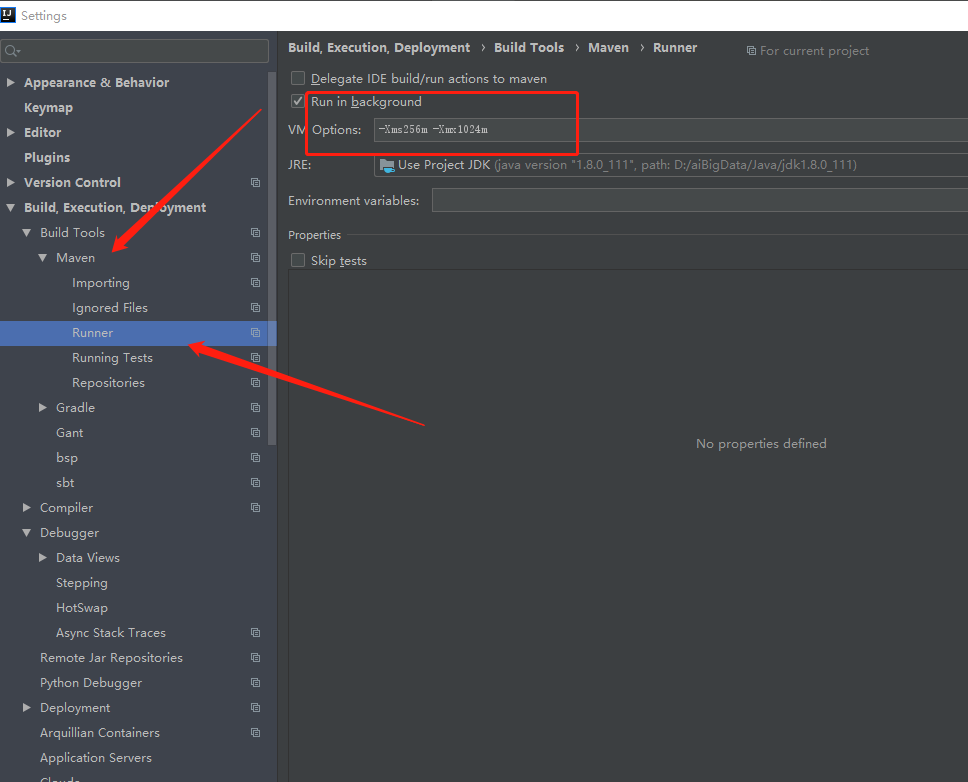

</plugin>3、maven打包时提示内存不足

在如图位置,VM Options增加内存就可以